Часть 1 | Часть 2

К прочтению обязательны — материал является их прямым продолжением.

В предыдущей части статьи были рассмотрены ключевые компоненты современного ПК, однако окончательного вывода сделано не было. Да, мы рассмотрели наиболее важные характеристики и их влияние на производительность. Зная это, можно взглянуть на предлагаеммый ассортимент и подобрать нужный девайс. Но за более высокие характеристики в любом случае придётся заплатить больше, а ведь это делать так не хочется…

Есть ли способы преодолеть различия между младшими и старшими моделями железок, или просто повысить производительность системы, не доплачивая за это? Определенно есть =)

Разгон это — эксплуатация компьютерных компонентов в нештатных режимах работы с целью повышения их быстродействия. Занятие, очень популярное среди железячников, а заодно и источник9000 огромного количества споров и холиваров =)

Очень часто, когда я кому-либо советую новое железо с ориентиром на дальнейший разгон, в ответ слышу «нет, ничего я разгонять не буду!». Переубедить людей оказывается очень сложно, иногда практически невозможно.

Для того, чтобы понять такое отношение, сначала нужно разобраться — что же есть разгон на практике.

Всего существуют два основных направления:

Экстремальный разгон

Данное занятие направлено на то, чтобы выжать из железа весь его потенциал любыми способами. Конечная цель — установка рекордов по максимальной частоте или максимального числа «попугаев» в каком-либо синтетическом бенчмарке. Для достижения результата применяются все возможные средства: экстремальное охлаждение (многокаскадные фреонки, сухой лёд, жидкий азот, жидкий гелий), модификация компонентов и т.д. Отбор железа для такой системы достаточно жесткий — вплоть до отдельных экземпляров, а от самого оверклокера требуется владение довольно большой теоретической базой и солидный практический опыт. Экстремальный разгон — занятие довольно рискованное, умертвить какую-либо железку по неопытности в таких условиях достаточно легко. Ну и главное — практической пользы это занятие не имеет, направлено оно исключительно на установку рекордов, демонстрацию предельных возможностей железа и просто получение фана.

Бытовой разгон

Совсем другое дело — разгон бытовой, конечной целью которого является увеличение производительности имеющегося железа с расчетом на долгосрочные (относительно) перспективны работы. Процесс выбора железа для системы «под разгон» сводится к покупке более «лояльных» и оптимальных компонентов. Однако никто не мешает разгонять вообще всё, что под руку попадётся ;) От самого оверклокера требуется знание лишь основных принципов и методов разгона, а так же некоторых особенностей конкретных железок. Риск же при грамотном выборе компонентов сводится к минимуму — в следствие наличия различных механизмов защиты убить современную систему довольно сложно, даже если это захочется сделать специально. И главное, в отличие от экстремального оверклокинга бытовой разгон имеет явную практическую пользу — бесплатный прирост производительности =)

Все стереотипы связанные с разгоном, а так же нелюбовь к этому занятию появляется из-за ассоциации у людей слова «разгон» исключительно с первым вариантом — экстремальным оверклокингом. Или с неудачным опытом бородатых времён, когда даже бытовой разгон был довольно сложной процедурой, а об экстремальном и не заикались. В настоящее же время бытовой оверклокинг не представляет из себя ничего особо сложного. Про него я и буду говорить в этой статье.

Перед тем как приступить к вопросам разгона отдельных компонентов, нельзя обойтись без пары слов о технической стороне разгона. Что вообще позволяет существовать этому явлению?

Ответ кроется в технологии производства полупроводниковых изделий, а именно на этапах контроля качества и отбраковки негодных чипов.

О контроле качества вы, наверное, слышали не раз. Суть его заключается в проведении серии различных тестов, которые определяют итоговое соответствие чипов требуемым характеристикам.

Важно здесь следующее:

Теперь перейдём к более приближенным вещам и рассмотрим разгон на примере основных компонентов системы, о которых шла речь в предыдущей части.

Описывать подробную методику разгона я тут не буду, рассмотрю лишь общие принципы. Главное — понять суть самого процесса и пользу, которую он может принести.

Как известно, частота ядер ЦП получается путем умножения частоты (реальной, а не эффективной) системной шины или системного генератора на множитель ЦП. Например, Intel Pentium DС E5200 имеет частоту 2500МГц при FSB 200МГц и множителе 12.5.

Чтобы изменять итоговую частоту придётся, соответственно, повышать либо шину, либо множитель.

Кстати говоря о множителе. В бородатые времена наличие разблокированного в сторону повышения множителя являлось чуть ли не единственной возможностью разогнать камень. Причина крылась в материнских платах — они совершенно не способствовали функционированию железа в нештатных режимах. Сейчас же картина совершенно иная — даже самые бюджетные железки позволяют менять основные параметры и способны держать более-менее неплохой разгон, не говоря уже о девайсах среднего класса и тем более о специальных оверклокерских моделях. Поэтому, если говорить о бытовом разгоне, свободный множитель вряд ли даст какие-то особые преимущества. Можно конечно вспомнить проблему FSB Strap (переключение режима работы чипсеты и резкое падение производительности после достижения определенной частоты FSB) на Intel P945 и P965 — но это всё дела ушедших дней.

Классический способ разгона процессоров и оперативной памяти — изменение параметров их работы в BIOS Setup.

Частота/множитель пошагово повышаются (вследствие хорошего разгонного потенциала современных ЦП первые шаги обычно большие, по мере увеличения частот они становятся меньше). Сначала выясняется максимальный режим работы, на котором компьютер способен загрузить операционную систему. После этого начинается этап нагрузочного тестирования. Наиболее распространенные и эффективные стресс-тесты ЦП/памяти — Linpack, S&M, OCCT, Everest Stress Test. По результатам их (не)прохождения частота/множитель понижаются до тех пор, пока система не будет стабильна.

Вспомогательным инструментом является напряжение на ядре, повышение которого может заметно улучшить результат. Безопасный диапазон его изменения составляет 5-15% от номинального значения, более высокое напряжение может привести к деградации кристалла или даже выходу его из строя. Другим неприятным моментом может стать отключение энергосберегающих технологий (которые полезны не только экономией, но и немного продлевают жизнь процессору) при выставлении любого напряжения кроме Auto на некоторых материнских платах. Впрочем, сейчас это встречается уже редко.

Альтернатива — разгон непосредственно из-под Windows с помощью специальных утилит (например, SetFSB). К применению не рекомендуется (хотя иногда без него не обойтись).

Оперативную память на время разгона ЦП рекомендуется использовать в максимально щадящем режиме — на настройках, не сильно отличающихся от заводских. Это конечно если разгонный потенциал конкретных модулей памяти заранее неизвестен (кстати, начать с его выяснения будет верным подходом).

Теперь о частотном потенциале ЦП. Зависит он напрямую от конкретного ядра и его степпинга, и у современных процессоров достаточно высок — если в былые времена уже 30% считалось очень хорошим приростом, то в последнее время железячники воротят нос от камней, неспособных работать на частоте, превышающей штатную в полтора раза.

AMD K8 и AMD K10 обладают скромными по сегодняшним меркам возможностями — их максимальные частоты лишь немного превышает 3ГГц, что делает разгон старших моделей бессмысленным занятием. Это, впрочем, не мешает гонять младшие камни до уровня старших.

AMD K10.5 в среднем хорошо гонятся до 3.2-3.6ГГц, в отдельных случаях преодолевая порог и в 4ГГц.

Intel Conroe покоряют частоты от 3 до 4ГГц. Хороший показатель для последних степпингов находится на уровне 3.2-3.6ГГц.

Intel Wolfdale без труда справляются с частотами в диапазоне 3.5-4ГГц, а многим экземплярам покоряется и 4.2-4.5ГГц.

При этом четырёхъядерные процессоры Conroe и Wolfdale в силу своих конструктивных особенностей гонятся хуже, чем их двуядерные собратья. Особенно расстраивают камни линейки Q8xxx, зачастую неспособные взять и 3.5ГГц.

Intel Nehalem во всех вариациях легко справляется с 3.8-4ГГц, в отдельных случаях — 4.2-4.5ГГц.

Заметьте, всё это — цифры, полученные на совершенно обычных системах с совершенно обычными материнскими платами и обычным (правда, хорошим) воздушным охлаждением. Никакого жидкого азота и аппаратных модификаций. Более того, нижние планки указанных диапазонов часто покоряются даже на стандартных боксовых кулерах и без поднятия напряжение на ядре.

Вообщем неплохой простор для деятельности.

Остаётся разобраться с пользой подобных мероприятий. Сравнивая штатные частоты современных процессоров с их потенциалом, можно сделать вывод, что разгон имеет смысл в любом случае и игнорировать его глупо даже если берётся изначально мощный процессор.

Но этот материал всё же посвящён проблеме выбора компьютера, поэтому поставим вопрос немного по-другому: стоит ли экономить на процессоре, чтобы освободить финансовые ресурсы на другие компоненты системы?

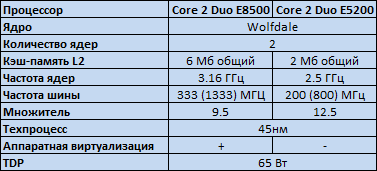

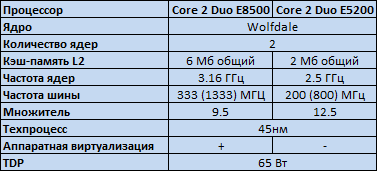

В качестве примера рассматриваются Core 2 Duo E8500, как типовое решение для производительных систем на платформе S775, и Pentium DС E5200, как представитель младшей линейки, но всё же не сильно урезанный по характеристикам.

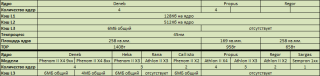

Процессоры выполнены на одном и том же ядре Wolfdale, их ключевые отличия:

Итак, в пользу E8500 на 26% более высокая частота, а так же 6Мб кэша. Вернёмся к предыдущей статье и посмотрим, что эта разница даёт на практике.

Максимальный прирост от повышения частоты — линейный, т.е. составляет те же 26%. Максимальный прирост от увеличения объёма кэш-памяти до 6Мб — 14%.

Задача: повысить производительность E5200 до уровня E8500 с помощью разгона.

Путём несложных расчетов (2500*1.26*1.14) приходим к выводу, что для этого нам будет достаточно 3.6ГГц. Вполне нормальная цифра для Wolfdale. Даже если учитывать, что не все приложения показывают линейную зависимость производительности от частоты — в теории всё уже замечательно. Однако, практика имеет свойство иногда расходиться с теорией.

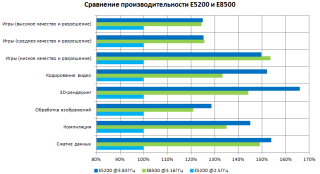

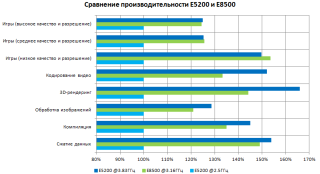

Вернёмся к результатам тестов. Благо, под рукой оказалась статья, в качестве одних из участников рассматривающая нужные нам девайсы — E8500 на штатной частоте и Pentium DC E5200, разогнанный до 3.83ГГц (+53%).

Вообщем-то всё понятно и без пояснений. Мы добились от E5200 производительности его старшего собрата, а где-то получили ещё более впечатляющий результат.

А теперь зглянем на цены. В качестве их источника я буду использовать прайс-лист Никса. Компания старая, авторитетная, с хорошими ценами, богатым ассортиментом и удобным прайсом.

201 доллар против 69. Разница почти троекратная.

Но, на стороне старшей модели пока остаётся ещё одно преимущество: как мы помним, E5200 лишён поддержки технологии аппаратной виртуализации Intel VT.

Важно для начала понимать — нужна ли вам она в действительности? И вообще, для чего она нужна?

Аппаратная виртуализация полезна (в плане производительности), когда требуется постоянное функционирование нескольких виртуальных машин.

Аппаратная виртуализация необходима если требуется запускать 64-битные гостевыы ОС на процессорах Intel — в силу особенности реализации набора инструкций EM64T без её поддержки это сделать невозможно. Процессоры AMD подобной проблемы лишены.

Если же вышеперечисленные случаи вас не касаются, а использовать виртуальную ось планируеться лишь изредка — чтобы проверить сомнительный файл на вирусы или ещё для чего — поддержка аппаратной виртуализации вообщем-то и не нужна.

Предположим, что вы всё-таки обнаружили острую необходимость в Intel VT.

Вернёмся к прайсу.

Чуть более высокая частота, около 10 долларов разницы в цене, и… Поддержка Intel VT. Как и Core 2 Duo E8xxx (за исключением E8190), линейка Pentium DC E6xxx (не путать с Core 2 Duo E6xxx — более старыми моделями на ядре Conroe) поддерживает Intel VT в полном составе. А более подробное изучение спеков обнаруживает необходимую опцию и у некоторых ревизий E5300 и E5400.

Я не буду приводить аналогичный пример для процессоров AMD — каждый может сам открыть прайс, сравнить характеристики, произвести элементарные расчеты и сделать вывод. Но совсем не упомянуть о продукции конкурентного лагеря я не могу — ведь их продукция в последнее время может порадовать оверклокера кое-чем более интересным, чем просто увеличение частоты.

Корни разблокировки растут оттуда же, откуда и у обычного частотного разгона — из процесса контроля качества выпускаемых изделий. Производителю просто не выгодно иметь большой зоопарк различных ядер — фабрика выпускает лишь несколько разновидностей кристаллов, отключая «лишние» блоки младших моделей на уровне микрокода. Отсев производится по тому же принципу, что и в случае с частотой, и соответственно отключение блока далеко не всегда подразумевает его неработоспособность.

Проблема заключается в том, что, в отличие от частоты, мы не можем просто взять и включить их обратно — приходится искать различные лазейки и недокументированные возможности. И именно AMD успела прославиться аж несколькими инцидентами, касающимися их камней.

Ещё во времена процессоров AMD K7 (Athlon, Athlon XP, Duron) энтузиасты часто занимались разблокировкой системного множителя, включением урезанной половины кэша L2 и превращением Athlon XP в Athlon MP (с поддержкой двухпроцессорных систем). Для этого нужно было соединить определенные контакты на корпусе процессора. Узнав про это, AMD начала вставлять палки в колеса, но энтузиасты всё равно находили способы получения халявы.

С тех пор о разблокировке вообщем-то ничего не было слышно. Во время царствования K8 порой мелькали отдельные случаи в новостях, но всё это было весьма сомнительно и характера массовости не приобрело.

Так было с процессорами поколения K10, и могло продолжаться и для самых современных K10.5, но спокойствие было нарушено.

Началось всё с того, что AMD выпустила новые южные мосты SB750 и SB710, одной из фич которых была функция Advanced Clock Calibration (ACC), призванная повысить стабильность процессоров при разгоне.

Из-за ошибки в реализации данной функции у неё оказался весьма приятный побочный эффект. Впервые он был обнаружен на процессоре Phenom II X3 720 Black Edition (специальная оверклокерская версия с разблокированным множителем) и выражался во включении изначально недоступного четвёртого ядра. Поднялся неслабый ажиотаж. Если сначала данную возможность приписывали именно серии Black Edition, то позже выяснилось что в какой-то мере этому подвержены вообще все процессоры AMD, причём не только современные K10.5, но и предыдущее поколение K10.

Разблокировать можно вообщем-то все возможности ядра, на котором выполнен процессор.

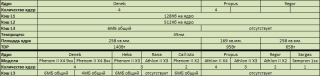

Например, для процессоров K10.5 картина такая:

Где-то можно разблокировать дополнительную кэш-память, где-то дополнительные ядра, где-то — всё сразу.

Очень интересно смотрятся в этом плане Phenom II X2 и Athlon II X3 на ядре Rana. Вероятность получения из них полноценного Phenom II X4 довольно высока, хотя порой попадаются и неудачные экземпляры. Если же хочется подстраховаться, более надежным вариантом является Phenom II X3 — они поддаются разблокировке практически поголовно.

И опять возможность получить не просто ту же производительность, а именно старший процессор за гораздо меньшую цену.

Все эти рассуждения не дают окончательного ответа на вопрос «какой же выбрать процессор», но определенные выводы сделать можно. В случае с Core 2 Duo, например, разница старших и младших процессоров при одинаковом разгоне сводится к разнице в объеме кэш-памяти, что уже не так существенно, как их изначальные отличия.

Процессор сейчас не является тем компонентом, который всегда во главе стола. Попытка ускорить систему, максимально вложившись именно в него, далеко не всегда принесёт ожидаемые результаты. Грамотный же выбор процессора и его последующий разгон может сэкономить достаточно серьёзную сумму, которую можно потратить на усиление других компонентов системы или просто оставить на другие цели.

Разгонять оперативную память можно по двум направлениям — увеличение частоты и уменьшение таймингов.

Вообще, в предыдущей статье был сделан вывод, что оба эти параметра при сегодняшних характеристиках памяти на производительность системы в целом влияют мало.

Однако, разгон памяти может понадобиться даже тогда, когда в принципе не планировался.

Проблема в том, что частота оперативной памяти задается не отдельным тактовым генератором, а синхронизируется с частотой системной шины или системного генератора посредством делителя. Оптимальным вариантом, конечно, является делитель 1:1, но на практике такой режим возможен далеко не всегда. Например, процессоры Core 2 Duo E8xxx имеют реальную частоту FSB 333МГц, а наиболее распространенные модули памяти DDR2 — 800МГц. Понижающий делитель оказывается необходим даже без разгона. Набор же его значений фиксирован и зависит от возможностей материнской платы — у бюджетных изделий он весьма ограничен (особенно как раз в сторону понижения). Так что при разгоне процессора по шине мы рано или поздно упираемся в ситуацию, когда даже с минимальным доступным делителем частота оперативной памяти начинает превышать дефолтную. И продолжая повышать частоту системной шины, мы поневоле разгоняем и память.

Естественно, память тоже имеют свой частотный порог. Он зависит от используемых чипов памяти (подробную информацию можно найти на тематических ресурсах) и выявляется экспериментальным способом.

Если порог достигнут — его можно попробовать поднять. Сделать это можно, повысив либо тайминги, либо напряжение на модулях памяти. Естественно, помогает это всё опять же только до определенного уровня. Каждый модуль памяти в любом случае имеет свой предел, после достижения которого повышению частоты не поможет уже ничто. Да и не стоит забывать, что напряжение тоже можно повышать не бесконечно, а лишь на 5-15% от номинала (например, для модулей DDR2 с родным напряжением 1.8В не рекомендуется повышать его до значений выше 2.1В).

Если делители позволяют выставить частоту, не сильно превышающую (или вообще не превышающую) стандартную — можно попробовать поиграться с таймингами. Большинство модулей позволяет их снизить на 1-2 ступени при небольшом повышении напряжения на модулях. Конечно, прирост производительности будет не велик — в лучшем случае 5%, но ведь и денег за это доплачивать не надо ;)

Вообще современная оперативная память гонятся весьма неплохо. Покупка же специальных оверклокерских модулей памяти, как правило, повышает успех мероприятия. Главное — не перестараться, потому что стоят такие решения порой в несколько раз дороже стандартных модулей, а о зависимости производительности системы от памяти выводы были сделаны ещё в предыдущей статье.

Ещё один важный момент, который следует учесть при разгоне памяти: сбой подсистемы ОП может привести к ошибкам чтения/записи, а соответственно потере данных на внешних носителя. Лично я сталкивался с этим дважды — переразгон памяти рушил таблицу разделов на системном HDD. Поэтому на время проведения данного мероприятия лучше отключить харды с важной информацией, а под рукой иметь загрузочный диск/флешку с менеджером разделов и утилитой восстановления.

Говоря о видеокарте, мы сталкиваемся с довольно интересной ситуацией. В отличие от ЦП, выпуском конечных продуктов занимается не непосредственно производитель ГП, а компании-партнёры, так называемые субвендоры. Конечно, существует и эталонный, так называемый референсный дизайн (и референсные характеристики), но строго его придерживаться вообщем-то никто не обязывает.

Простор деятельности субвендоров достаточно широк. Можно выпустить полностью уникальный продукт, оставив от оригинального только ГП и общую логику организации. При этом каждое изменение может быть сделано двумя способами — в сторону улучшения, или наоборот упрощения.

Поэтому, при покупке видеокарты нужно очень внимательно выбирать конечную модель — несмотря на кажущуюся близость названий, железки могут очень сильно отличаться.

Что выбирать — референс или нереференс — дело каждого, и вообще зависит от конкретного случая. Есть изначально хорошие продукты, не нуждающиеся в доработке, а есть не совсем удачные решения. Особенно остро данная проблема касается систем охлаждения продуктов среднего ценового сектора — непосредственно со своей задачей они, конечно, справляются, но при этом, как правило, ощутимо шумят. А если заниматься разгоном — их мощности может и не хватить. В качестве примера таких «плохих» решений можно привести референсные СО GeForce 8800GT/9800GT и Radeon HD4850/4830. В качестве примеров изначально хороших продуктов — GeForce 9800GTX и Radeon HD5700.

Помимо внесения изменений в конструкцию самой видеокарты, субвендоры очень любят выпускать изделия с нестандартными частотами (и прочими параметрами). Подходов к этому имеется два.

Первый — простой. Частота ГП поднимается на 50МГц, памяти на 100, к цене прибавляется десяток-другой убитых енотов и девайс отправляется на прилавок. Для субвендора ситуация вообщем-то беспроигрышная — такие незначительные манипуляции с частотами видеокарты выдерживают практически поголовно, т.е. риск минимален. Прирост производительности от этого несерьёзен, но расходятся такие железки среди определенной аудитории «на ура».

Другой подход более честный. Во-первых, тут уже не обходится без собственных PCB и СО. Частоты повышаются более серьёзно. Иногда даже производится специальный отбор чипов с лучшим частотным потенциалом. Продукт такой, бывает, стоит заметно дороже стокового варианта, но и отличия более заметны.

Впрочем, ситуация может быть обратной. Многие производители не упускают возможность заработать на фанатиках различных экологично-зеленых технологий, выпуская девайсы с суффиксами ECO или Green в названии. Отличаются они от референсных вариантов пониженным энергопотреблением, которое, как нетрудно догадаться, достигается путём уменьшения рабочих частот.

Иногда бывают случаи, когда на видеокарту ставится более медленная память по сравнению с референсной, или урезается шина памяти. При этом цена на девайс оказывается ниже, а вот на названии эти манипуляции отражаются далеко не всегда. Что интересно, уличены в подобных деяниях были не только «вендоры второго сорта», но и такие именитые компании как, например, ASUS (видеокарты Magic).

Разгон видеокарт заключается в повышении частот ГП и видеопамяти.

Наиболее распространенный способ — с помощью специальных утилит. Можно использовать как фирменные программы от производителей, так и альтернативные универсальные решения (RivaTuner, ATI Tray Tools). Лично мне больше по душе второй вариант, хотя иногда лучше и удобнее оказывается использовать именно фирменные утилиты.

Другая методика — прошивка измененных параметров непосредственно в BIOS видеоадаптера. Применяется это уже, как правило, после того, как выяснены максимально стабильные частоты. Цель ясна — «прошить и забыть» =)

Повысить частотный порог можно опять же подняв напряжение. С этим сложнее. Некоторые видеокарты позволяют управлять напряжением на ядре и памяти с помощью тех же фирменных утилит. Некоторым нужное значение можно прошить в BIOS. Есть экзотические продукты, позволяющие переключать напряжение перестановкой перемычек (джамперов) на карте. Ну и весьма значительную частьзоопарка ассортимента видеокарт составляют девайсы, для управления напряжением на которых понадобятся некоторые знания по электронике, а так же умение обращаться с паяльником.

Тестирование видеокарт на стабильность включает в себя два основных момента:

Тест на артефакты и перегрев. Наиболее эффективными в этой области являются «волосатые бублики» — FurMark и OCCT 3. «Волосатый куб» ATITool прогревает железку не так сильно, но быстрее выявляет артефакты изображения. Как альтернативу (или лучше дополнение) можно посоветовать многократный прогон основных игровых тестов 3DMark, или просто тяжелые игры;

Тест на фризы. Довольно хорошо их выявляют первые тесты 3DMark 05/06, а так же некоторые игры. Из личного опыта — NFS ProStreet зависал на карте, успешной отработавшей 15 минут под бубликом и 10 проходов игровых тестов 06 марка.

Что касается разблокировки — тут опять же халява обитает в лагере AMD. Явление это, правда, нечастое, но иногда в новостях мелькают успешные случаи, а в сети появляются модифицированные BIOS'ы, позволяющие вернуть видеокарте отключенные блоки. Из последнего можно припомнить разлочку всех 800 шейдерных блоков на некоторых HD4830, что фактически превращало её в полноценную более дорогую HD4850.

Вообще, видеокарта — не та вещь, на которой стоит экономить, если речь заходит об играх. Добиться с помощью разгона и прочих манипуляций от младших моделей результатов уровня старших не получится, однако игнорировать его тоже нельзя. Разгон позволяет неплохо повысить производительность системы, причём касается это вообщем-то всех видеокарт. Девайсы среднего класса, полученные урезанием старших моделей гонятся хорошо по определению, а младшие карточки обладают низким TDP, что на разгоне так же сказывается положительно. Примеры и графики приводить не буду, благо соответствующих обзоров в сети вагон и маленькая тележка.

И ещё небольшое замечание насчёт multi-GPU систем. Многочиповые видеокарты обладают заметно большим TDP, нежели одночиповые решения, вследствие чего их гораздо сложнее охлаждать. Установка же нескольких видеокарт близко друг к другу повышает температуру окружающего пространства. В обоих этих случаях разгон видеокарт связан с дополнительными трудностями и железки показывают худшие результаты, чем в одиночных конфигурациях.

При разгоне компонентов (особенно с повышением их напряжения) повышается их энергопотребление и тепловыделение. Это даёт важные следствия:

1. Для разогнанных компонентов необходимо более эффективное охлаждение;

2. Для разогнанной системы необходима большая мощность блока питания.

Именно пренебрежительное отношение к этим двум следствиям порождает проблемы в процессе разгона.

3. Разогнанная система менее экономична в плане потребления электроэнергии.

А это ставит под большой вопрос целесообразность разгона ноутбуков.

Подробному разбору вопросов питания и охлаждения будет посвящена данного материала. Пока же просто стоит запомнить и усвоить эти важные замечания.

А ещё выход железа из строя вследствие разгона является негарантийным случаем. Хотя в не очень прямых руках вообще что угодно сломаться может ;)

Знание некоторых железных тонкостей открывает перед пользователем новые, прежде скрытые горизонты.

Разгон представляет собой отличный способ повысить производительность своей системы, ничего не потеряв, а игнорирование такой возможности — настоящее кощунство.

На этом проблему выбора ключевых компонентов можно считать решённой. Конечно, не на все вопросы были даны ответы, но определенная ясность в ситуацию уже внесена. Если что-то совсем непонятно — готов ответить в комментариях ;)

Следующая же часть материала будет посвящена ещё одному очень важному компоненту системы — материнской плате.

P.S. Извиняюсь за двухнедельную задержку, но всё никак не получалось довести статью до ума. То дела, то просто «креатифф не пёр». Вот только сегодня закончил. Сейчас со временем вроде стало посвободнее, так что следующие части будут выходить быстрее =)

P.P.S. Ещё раз напоминаю, что данный цикл статей направлен не на гуру-железячников, техноманьяков и экстремальных оверклокеров, а на обычных людей, близких к IT, но плохо разбирающихся именно в железной области.

P.P.P.S.

К прочтению обязательны — материал является их прямым продолжением.

В предыдущей части статьи были рассмотрены ключевые компоненты современного ПК, однако окончательного вывода сделано не было. Да, мы рассмотрели наиболее важные характеристики и их влияние на производительность. Зная это, можно взглянуть на предлагаеммый ассортимент и подобрать нужный девайс. Но за более высокие характеристики в любом случае придётся заплатить больше, а ведь это делать так не хочется…

Есть ли способы преодолеть различия между младшими и старшими моделями железок, или просто повысить производительность системы, не доплачивая за это? Определенно есть =)

Часть 3. Скрытые горизонты

— Горячие финские парни разогнали Radeon до 1 ГГц!

— Теперь не могут догнать?

Разгон это — эксплуатация компьютерных компонентов в нештатных режимах работы с целью повышения их быстродействия. Занятие, очень популярное среди железячников, а заодно и источник

Очень часто, когда я кому-либо советую новое железо с ориентиром на дальнейший разгон, в ответ слышу «нет, ничего я разгонять не буду!». Переубедить людей оказывается очень сложно, иногда практически невозможно.

Для того, чтобы понять такое отношение, сначала нужно разобраться — что же есть разгон на практике.

Всего существуют два основных направления:

Экстремальный разгон

Данное занятие направлено на то, чтобы выжать из железа весь его потенциал любыми способами. Конечная цель — установка рекордов по максимальной частоте или максимального числа «попугаев» в каком-либо синтетическом бенчмарке. Для достижения результата применяются все возможные средства: экстремальное охлаждение (многокаскадные фреонки, сухой лёд, жидкий азот, жидкий гелий), модификация компонентов и т.д. Отбор железа для такой системы достаточно жесткий — вплоть до отдельных экземпляров, а от самого оверклокера требуется владение довольно большой теоретической базой и солидный практический опыт. Экстремальный разгон — занятие довольно рискованное, умертвить какую-либо железку по неопытности в таких условиях достаточно легко. Ну и главное — практической пользы это занятие не имеет, направлено оно исключительно на установку рекордов, демонстрацию предельных возможностей железа и просто получение фана.

Бытовой разгон

Совсем другое дело — разгон бытовой, конечной целью которого является увеличение производительности имеющегося железа с расчетом на долгосрочные (относительно) перспективны работы. Процесс выбора железа для системы «под разгон» сводится к покупке более «лояльных» и оптимальных компонентов. Однако никто не мешает разгонять вообще всё, что под руку попадётся ;) От самого оверклокера требуется знание лишь основных принципов и методов разгона, а так же некоторых особенностей конкретных железок. Риск же при грамотном выборе компонентов сводится к минимуму — в следствие наличия различных механизмов защиты убить современную систему довольно сложно, даже если это захочется сделать специально. И главное, в отличие от экстремального оверклокинга бытовой разгон имеет явную практическую пользу — бесплатный прирост производительности =)

Все стереотипы связанные с разгоном, а так же нелюбовь к этому занятию появляется из-за ассоциации у людей слова «разгон» исключительно с первым вариантом — экстремальным оверклокингом. Или с неудачным опытом бородатых времён, когда даже бытовой разгон был довольно сложной процедурой, а об экстремальном и не заикались. В настоящее же время бытовой оверклокинг не представляет из себя ничего особо сложного. Про него я и буду говорить в этой статье.

Что? Где? Когда?

Перед тем как приступить к вопросам разгона отдельных компонентов, нельзя обойтись без пары слов о технической стороне разгона. Что вообще позволяет существовать этому явлению?

Ответ кроется в технологии производства полупроводниковых изделий, а именно на этапах контроля качества и отбраковки негодных чипов.

О контроле качества вы, наверное, слышали не раз. Суть его заключается в проведении серии различных тестов, которые определяют итоговое соответствие чипов требуемым характеристикам.

Важно здесь следующее:

- 1. Применяется многоуровневая система тестов. Сначала чипы проходят проверку на максимально возможных для своей ревизии параметрах — частота, верное функционирование всех блоков и т.д. Если контроль не пройден — применяется более мягкий тест, для отбора чипов, которые в последствии будут маркированы как более младшая в линейке модель.

- 2. Контроль качества производится партиями. Конечно, тесты проходит каждый чип (по крайней мере нам так говорят производители), но, учитывая объёмы производства, оперировать на фабрике приходится всё равно партиями. И если тест высокого уровня завалил хотя бы один чип из партии, этого достаточно, чтобы она ПОЛНОСТЬЮ ушла на следующий, более низкий уровень. А чем лучше отлажен техпроцесс — тем меньше в партии «провальных» чипов ;)

- 3. Дальнейшая отладка техпроцесса может привести к тому, что лишь мизерный процент производимых кристаллов не проходит тесты верхнего уровня. Т.е. грубо говоря, их все можно маркировать и пускать в продажу как старшую модель. По понятным причинам этого не делается, а чипы, несмотря на прохождение «старших» тестов маркируются как младшие модели.

- Из этих трёх утверждений напрашивается логичный вывод — младшие модели чипов, полученные путём отбраковки, с довольно большой вероятностью могут функционировать на параметрах старших моделей.

Теперь перейдём к более приближенным вещам и рассмотрим разгон на примере основных компонентов системы, о которых шла речь в предыдущей части.

Описывать подробную методику разгона я тут не буду, рассмотрю лишь общие принципы. Главное — понять суть самого процесса и пользу, которую он может принести.

Центральный процессор

Как известно, частота ядер ЦП получается путем умножения частоты (реальной, а не эффективной) системной шины или системного генератора на множитель ЦП. Например, Intel Pentium DС E5200 имеет частоту 2500МГц при FSB 200МГц и множителе 12.5.

Чтобы изменять итоговую частоту придётся, соответственно, повышать либо шину, либо множитель.

Кстати говоря о множителе. В бородатые времена наличие разблокированного в сторону повышения множителя являлось чуть ли не единственной возможностью разогнать камень. Причина крылась в материнских платах — они совершенно не способствовали функционированию железа в нештатных режимах. Сейчас же картина совершенно иная — даже самые бюджетные железки позволяют менять основные параметры и способны держать более-менее неплохой разгон, не говоря уже о девайсах среднего класса и тем более о специальных оверклокерских моделях. Поэтому, если говорить о бытовом разгоне, свободный множитель вряд ли даст какие-то особые преимущества. Можно конечно вспомнить проблему FSB Strap (переключение режима работы чипсеты и резкое падение производительности после достижения определенной частоты FSB) на Intel P945 и P965 — но это всё дела ушедших дней.

Классический способ разгона процессоров и оперативной памяти — изменение параметров их работы в BIOS Setup.

Частота/множитель пошагово повышаются (вследствие хорошего разгонного потенциала современных ЦП первые шаги обычно большие, по мере увеличения частот они становятся меньше). Сначала выясняется максимальный режим работы, на котором компьютер способен загрузить операционную систему. После этого начинается этап нагрузочного тестирования. Наиболее распространенные и эффективные стресс-тесты ЦП/памяти — Linpack, S&M, OCCT, Everest Stress Test. По результатам их (не)прохождения частота/множитель понижаются до тех пор, пока система не будет стабильна.

Вспомогательным инструментом является напряжение на ядре, повышение которого может заметно улучшить результат. Безопасный диапазон его изменения составляет 5-15% от номинального значения, более высокое напряжение может привести к деградации кристалла или даже выходу его из строя. Другим неприятным моментом может стать отключение энергосберегающих технологий (которые полезны не только экономией, но и немного продлевают жизнь процессору) при выставлении любого напряжения кроме Auto на некоторых материнских платах. Впрочем, сейчас это встречается уже редко.

Альтернатива — разгон непосредственно из-под Windows с помощью специальных утилит (например, SetFSB). К применению не рекомендуется (хотя иногда без него не обойтись).

Оперативную память на время разгона ЦП рекомендуется использовать в максимально щадящем режиме — на настройках, не сильно отличающихся от заводских. Это конечно если разгонный потенциал конкретных модулей памяти заранее неизвестен (кстати, начать с его выяснения будет верным подходом).

Теперь о частотном потенциале ЦП. Зависит он напрямую от конкретного ядра и его степпинга, и у современных процессоров достаточно высок — если в былые времена уже 30% считалось очень хорошим приростом, то в последнее время железячники воротят нос от камней, неспособных работать на частоте, превышающей штатную в полтора раза.

AMD K8 и AMD K10 обладают скромными по сегодняшним меркам возможностями — их максимальные частоты лишь немного превышает 3ГГц, что делает разгон старших моделей бессмысленным занятием. Это, впрочем, не мешает гонять младшие камни до уровня старших.

AMD K10.5 в среднем хорошо гонятся до 3.2-3.6ГГц, в отдельных случаях преодолевая порог и в 4ГГц.

Intel Conroe покоряют частоты от 3 до 4ГГц. Хороший показатель для последних степпингов находится на уровне 3.2-3.6ГГц.

Intel Wolfdale без труда справляются с частотами в диапазоне 3.5-4ГГц, а многим экземплярам покоряется и 4.2-4.5ГГц.

При этом четырёхъядерные процессоры Conroe и Wolfdale в силу своих конструктивных особенностей гонятся хуже, чем их двуядерные собратья. Особенно расстраивают камни линейки Q8xxx, зачастую неспособные взять и 3.5ГГц.

Intel Nehalem во всех вариациях легко справляется с 3.8-4ГГц, в отдельных случаях — 4.2-4.5ГГц.

Заметьте, всё это — цифры, полученные на совершенно обычных системах с совершенно обычными материнскими платами и обычным (правда, хорошим) воздушным охлаждением. Никакого жидкого азота и аппаратных модификаций. Более того, нижние планки указанных диапазонов часто покоряются даже на стандартных боксовых кулерах и без поднятия напряжение на ядре.

Вообщем неплохой простор для деятельности.

Остаётся разобраться с пользой подобных мероприятий. Сравнивая штатные частоты современных процессоров с их потенциалом, можно сделать вывод, что разгон имеет смысл в любом случае и игнорировать его глупо даже если берётся изначально мощный процессор.

Но этот материал всё же посвящён проблеме выбора компьютера, поэтому поставим вопрос немного по-другому: стоит ли экономить на процессоре, чтобы освободить финансовые ресурсы на другие компоненты системы?

В качестве примера рассматриваются Core 2 Duo E8500, как типовое решение для производительных систем на платформе S775, и Pentium DС E5200, как представитель младшей линейки, но всё же не сильно урезанный по характеристикам.

Процессоры выполнены на одном и том же ядре Wolfdale, их ключевые отличия:

Итак, в пользу E8500 на 26% более высокая частота, а так же 6Мб кэша. Вернёмся к предыдущей статье и посмотрим, что эта разница даёт на практике.

Максимальный прирост от повышения частоты — линейный, т.е. составляет те же 26%. Максимальный прирост от увеличения объёма кэш-памяти до 6Мб — 14%.

Задача: повысить производительность E5200 до уровня E8500 с помощью разгона.

Путём несложных расчетов (2500*1.26*1.14) приходим к выводу, что для этого нам будет достаточно 3.6ГГц. Вполне нормальная цифра для Wolfdale. Даже если учитывать, что не все приложения показывают линейную зависимость производительности от частоты — в теории всё уже замечательно. Однако, практика имеет свойство иногда расходиться с теорией.

Вернёмся к результатам тестов. Благо, под рукой оказалась статья, в качестве одних из участников рассматривающая нужные нам девайсы — E8500 на штатной частоте и Pentium DC E5200, разогнанный до 3.83ГГц (+53%).

Вообщем-то всё понятно и без пояснений. Мы добились от E5200 производительности его старшего собрата, а где-то получили ещё более впечатляющий результат.

А теперь зглянем на цены. В качестве их источника я буду использовать прайс-лист Никса. Компания старая, авторитетная, с хорошими ценами, богатым ассортиментом и удобным прайсом.

CPU Intel Core 2 Duo E8500 3.16 ГГц/ 6Мб/ 1333МГц LGA775 201

CPU Intel Pentium Dual-Core E5200 2.5 ГГц/ 2Мб/ 800МГц LGA775 69

201 доллар против 69. Разница почти троекратная.

Но, на стороне старшей модели пока остаётся ещё одно преимущество: как мы помним, E5200 лишён поддержки технологии аппаратной виртуализации Intel VT.

Важно для начала понимать — нужна ли вам она в действительности? И вообще, для чего она нужна?

Аппаратная виртуализация полезна (в плане производительности), когда требуется постоянное функционирование нескольких виртуальных машин.

Аппаратная виртуализация необходима если требуется запускать 64-битные гостевыы ОС на процессорах Intel — в силу особенности реализации набора инструкций EM64T без её поддержки это сделать невозможно. Процессоры AMD подобной проблемы лишены.

Если же вышеперечисленные случаи вас не касаются, а использовать виртуальную ось планируеться лишь изредка — чтобы проверить сомнительный файл на вирусы или ещё для чего — поддержка аппаратной виртуализации вообщем-то и не нужна.

Предположим, что вы всё-таки обнаружили острую необходимость в Intel VT.

Вернёмся к прайсу.

CPU Intel Pentium E6300 2.8 ГГц/ 2Мб/ 1066МГц LGA775 81

Чуть более высокая частота, около 10 долларов разницы в цене, и… Поддержка Intel VT. Как и Core 2 Duo E8xxx (за исключением E8190), линейка Pentium DC E6xxx (не путать с Core 2 Duo E6xxx — более старыми моделями на ядре Conroe) поддерживает Intel VT в полном составе. А более подробное изучение спеков обнаруживает необходимую опцию и у некоторых ревизий E5300 и E5400.

Я не буду приводить аналогичный пример для процессоров AMD — каждый может сам открыть прайс, сравнить характеристики, произвести элементарные расчеты и сделать вывод. Но совсем не упомянуть о продукции конкурентного лагеря я не могу — ведь их продукция в последнее время может порадовать оверклокера кое-чем более интересным, чем просто увеличение частоты.

Разблокировка

Корни разблокировки растут оттуда же, откуда и у обычного частотного разгона — из процесса контроля качества выпускаемых изделий. Производителю просто не выгодно иметь большой зоопарк различных ядер — фабрика выпускает лишь несколько разновидностей кристаллов, отключая «лишние» блоки младших моделей на уровне микрокода. Отсев производится по тому же принципу, что и в случае с частотой, и соответственно отключение блока далеко не всегда подразумевает его неработоспособность.

Проблема заключается в том, что, в отличие от частоты, мы не можем просто взять и включить их обратно — приходится искать различные лазейки и недокументированные возможности. И именно AMD успела прославиться аж несколькими инцидентами, касающимися их камней.

Ещё во времена процессоров AMD K7 (Athlon, Athlon XP, Duron) энтузиасты часто занимались разблокировкой системного множителя, включением урезанной половины кэша L2 и превращением Athlon XP в Athlon MP (с поддержкой двухпроцессорных систем). Для этого нужно было соединить определенные контакты на корпусе процессора. Узнав про это, AMD начала вставлять палки в колеса, но энтузиасты всё равно находили способы получения халявы.

С тех пор о разблокировке вообщем-то ничего не было слышно. Во время царствования K8 порой мелькали отдельные случаи в новостях, но всё это было весьма сомнительно и характера массовости не приобрело.

Так было с процессорами поколения K10, и могло продолжаться и для самых современных K10.5, но спокойствие было нарушено.

Началось всё с того, что AMD выпустила новые южные мосты SB750 и SB710, одной из фич которых была функция Advanced Clock Calibration (ACC), призванная повысить стабильность процессоров при разгоне.

Из-за ошибки в реализации данной функции у неё оказался весьма приятный побочный эффект. Впервые он был обнаружен на процессоре Phenom II X3 720 Black Edition (специальная оверклокерская версия с разблокированным множителем) и выражался во включении изначально недоступного четвёртого ядра. Поднялся неслабый ажиотаж. Если сначала данную возможность приписывали именно серии Black Edition, то позже выяснилось что в какой-то мере этому подвержены вообще все процессоры AMD, причём не только современные K10.5, но и предыдущее поколение K10.

Разблокировать можно вообщем-то все возможности ядра, на котором выполнен процессор.

Например, для процессоров K10.5 картина такая:

Где-то можно разблокировать дополнительную кэш-память, где-то дополнительные ядра, где-то — всё сразу.

Очень интересно смотрятся в этом плане Phenom II X2 и Athlon II X3 на ядре Rana. Вероятность получения из них полноценного Phenom II X4 довольно высока, хотя порой попадаются и неудачные экземпляры. Если же хочется подстраховаться, более надежным вариантом является Phenom II X3 — они поддаются разблокировке практически поголовно.

CPU AMD Phenom II X4 945 3.0 ГГц/ 2+6 Мб/ 4000 МГц Socket AM3 189

CPU AMD Phenom II X4 925 2.8 ГГц/ 2+6Мб/4000 МГц Socket AM3 179

CPU AMD Phenom II X3 720 2.8 ГГц/ 1.5+6Мб/4000 МГц Socket AM3 144

CPU AMD Athlon II X3 425 2.7 ГГц/ 1.5Мб/ 4000МГцSocket AM3 81

И опять возможность получить не просто ту же производительность, а именно старший процессор за гораздо меньшую цену.

Все эти рассуждения не дают окончательного ответа на вопрос «какой же выбрать процессор», но определенные выводы сделать можно. В случае с Core 2 Duo, например, разница старших и младших процессоров при одинаковом разгоне сводится к разнице в объеме кэш-памяти, что уже не так существенно, как их изначальные отличия.

Процессор сейчас не является тем компонентом, который всегда во главе стола. Попытка ускорить систему, максимально вложившись именно в него, далеко не всегда принесёт ожидаемые результаты. Грамотный же выбор процессора и его последующий разгон может сэкономить достаточно серьёзную сумму, которую можно потратить на усиление других компонентов системы или просто оставить на другие цели.

Оперативная память

Разгонять оперативную память можно по двум направлениям — увеличение частоты и уменьшение таймингов.

Вообще, в предыдущей статье был сделан вывод, что оба эти параметра при сегодняшних характеристиках памяти на производительность системы в целом влияют мало.

Однако, разгон памяти может понадобиться даже тогда, когда в принципе не планировался.

Проблема в том, что частота оперативной памяти задается не отдельным тактовым генератором, а синхронизируется с частотой системной шины или системного генератора посредством делителя. Оптимальным вариантом, конечно, является делитель 1:1, но на практике такой режим возможен далеко не всегда. Например, процессоры Core 2 Duo E8xxx имеют реальную частоту FSB 333МГц, а наиболее распространенные модули памяти DDR2 — 800МГц. Понижающий делитель оказывается необходим даже без разгона. Набор же его значений фиксирован и зависит от возможностей материнской платы — у бюджетных изделий он весьма ограничен (особенно как раз в сторону понижения). Так что при разгоне процессора по шине мы рано или поздно упираемся в ситуацию, когда даже с минимальным доступным делителем частота оперативной памяти начинает превышать дефолтную. И продолжая повышать частоту системной шины, мы поневоле разгоняем и память.

Естественно, память тоже имеют свой частотный порог. Он зависит от используемых чипов памяти (подробную информацию можно найти на тематических ресурсах) и выявляется экспериментальным способом.

Если порог достигнут — его можно попробовать поднять. Сделать это можно, повысив либо тайминги, либо напряжение на модулях памяти. Естественно, помогает это всё опять же только до определенного уровня. Каждый модуль памяти в любом случае имеет свой предел, после достижения которого повышению частоты не поможет уже ничто. Да и не стоит забывать, что напряжение тоже можно повышать не бесконечно, а лишь на 5-15% от номинала (например, для модулей DDR2 с родным напряжением 1.8В не рекомендуется повышать его до значений выше 2.1В).

Если делители позволяют выставить частоту, не сильно превышающую (или вообще не превышающую) стандартную — можно попробовать поиграться с таймингами. Большинство модулей позволяет их снизить на 1-2 ступени при небольшом повышении напряжения на модулях. Конечно, прирост производительности будет не велик — в лучшем случае 5%, но ведь и денег за это доплачивать не надо ;)

Вообще современная оперативная память гонятся весьма неплохо. Покупка же специальных оверклокерских модулей памяти, как правило, повышает успех мероприятия. Главное — не перестараться, потому что стоят такие решения порой в несколько раз дороже стандартных модулей, а о зависимости производительности системы от памяти выводы были сделаны ещё в предыдущей статье.

Ещё один важный момент, который следует учесть при разгоне памяти: сбой подсистемы ОП может привести к ошибкам чтения/записи, а соответственно потере данных на внешних носителя. Лично я сталкивался с этим дважды — переразгон памяти рушил таблицу разделов на системном HDD. Поэтому на время проведения данного мероприятия лучше отключить харды с важной информацией, а под рукой иметь загрузочный диск/флешку с менеджером разделов и утилитой восстановления.

Видеокарта

Говоря о видеокарте, мы сталкиваемся с довольно интересной ситуацией. В отличие от ЦП, выпуском конечных продуктов занимается не непосредственно производитель ГП, а компании-партнёры, так называемые субвендоры. Конечно, существует и эталонный, так называемый референсный дизайн (и референсные характеристики), но строго его придерживаться вообщем-то никто не обязывает.

Простор деятельности субвендоров достаточно широк. Можно выпустить полностью уникальный продукт, оставив от оригинального только ГП и общую логику организации. При этом каждое изменение может быть сделано двумя способами — в сторону улучшения, или наоборот упрощения.

Поэтому, при покупке видеокарты нужно очень внимательно выбирать конечную модель — несмотря на кажущуюся близость названий, железки могут очень сильно отличаться.

Что выбирать — референс или нереференс — дело каждого, и вообще зависит от конкретного случая. Есть изначально хорошие продукты, не нуждающиеся в доработке, а есть не совсем удачные решения. Особенно остро данная проблема касается систем охлаждения продуктов среднего ценового сектора — непосредственно со своей задачей они, конечно, справляются, но при этом, как правило, ощутимо шумят. А если заниматься разгоном — их мощности может и не хватить. В качестве примера таких «плохих» решений можно привести референсные СО GeForce 8800GT/9800GT и Radeon HD4850/4830. В качестве примеров изначально хороших продуктов — GeForce 9800GTX и Radeon HD5700.

Помимо внесения изменений в конструкцию самой видеокарты, субвендоры очень любят выпускать изделия с нестандартными частотами (и прочими параметрами). Подходов к этому имеется два.

Первый — простой. Частота ГП поднимается на 50МГц, памяти на 100, к цене прибавляется десяток-другой убитых енотов и девайс отправляется на прилавок. Для субвендора ситуация вообщем-то беспроигрышная — такие незначительные манипуляции с частотами видеокарты выдерживают практически поголовно, т.е. риск минимален. Прирост производительности от этого несерьёзен, но расходятся такие железки среди определенной аудитории «на ура».

Другой подход более честный. Во-первых, тут уже не обходится без собственных PCB и СО. Частоты повышаются более серьёзно. Иногда даже производится специальный отбор чипов с лучшим частотным потенциалом. Продукт такой, бывает, стоит заметно дороже стокового варианта, но и отличия более заметны.

Впрочем, ситуация может быть обратной. Многие производители не упускают возможность заработать на фанатиках различных экологично-зеленых технологий, выпуская девайсы с суффиксами ECO или Green в названии. Отличаются они от референсных вариантов пониженным энергопотреблением, которое, как нетрудно догадаться, достигается путём уменьшения рабочих частот.

Иногда бывают случаи, когда на видеокарту ставится более медленная память по сравнению с референсной, или урезается шина памяти. При этом цена на девайс оказывается ниже, а вот на названии эти манипуляции отражаются далеко не всегда. Что интересно, уличены в подобных деяниях были не только «вендоры второго сорта», но и такие именитые компании как, например, ASUS (видеокарты Magic).

Разгон видеокарт заключается в повышении частот ГП и видеопамяти.

Наиболее распространенный способ — с помощью специальных утилит. Можно использовать как фирменные программы от производителей, так и альтернативные универсальные решения (RivaTuner, ATI Tray Tools). Лично мне больше по душе второй вариант, хотя иногда лучше и удобнее оказывается использовать именно фирменные утилиты.

Другая методика — прошивка измененных параметров непосредственно в BIOS видеоадаптера. Применяется это уже, как правило, после того, как выяснены максимально стабильные частоты. Цель ясна — «прошить и забыть» =)

Повысить частотный порог можно опять же подняв напряжение. С этим сложнее. Некоторые видеокарты позволяют управлять напряжением на ядре и памяти с помощью тех же фирменных утилит. Некоторым нужное значение можно прошить в BIOS. Есть экзотические продукты, позволяющие переключать напряжение перестановкой перемычек (джамперов) на карте. Ну и весьма значительную часть

Тестирование видеокарт на стабильность включает в себя два основных момента:

Тест на артефакты и перегрев. Наиболее эффективными в этой области являются «волосатые бублики» — FurMark и OCCT 3. «Волосатый куб» ATITool прогревает железку не так сильно, но быстрее выявляет артефакты изображения. Как альтернативу (или лучше дополнение) можно посоветовать многократный прогон основных игровых тестов 3DMark, или просто тяжелые игры;

Тест на фризы. Довольно хорошо их выявляют первые тесты 3DMark 05/06, а так же некоторые игры. Из личного опыта — NFS ProStreet зависал на карте, успешной отработавшей 15 минут под бубликом и 10 проходов игровых тестов 06 марка.

Что касается разблокировки — тут опять же халява обитает в лагере AMD. Явление это, правда, нечастое, но иногда в новостях мелькают успешные случаи, а в сети появляются модифицированные BIOS'ы, позволяющие вернуть видеокарте отключенные блоки. Из последнего можно припомнить разлочку всех 800 шейдерных блоков на некоторых HD4830, что фактически превращало её в полноценную более дорогую HD4850.

Вообще, видеокарта — не та вещь, на которой стоит экономить, если речь заходит об играх. Добиться с помощью разгона и прочих манипуляций от младших моделей результатов уровня старших не получится, однако игнорировать его тоже нельзя. Разгон позволяет неплохо повысить производительность системы, причём касается это вообщем-то всех видеокарт. Девайсы среднего класса, полученные урезанием старших моделей гонятся хорошо по определению, а младшие карточки обладают низким TDP, что на разгоне так же сказывается положительно. Примеры и графики приводить не буду, благо соответствующих обзоров в сети вагон и маленькая тележка.

И ещё небольшое замечание насчёт multi-GPU систем. Многочиповые видеокарты обладают заметно большим TDP, нежели одночиповые решения, вследствие чего их гораздо сложнее охлаждать. Установка же нескольких видеокарт близко друг к другу повышает температуру окружающего пространства. В обоих этих случаях разгон видеокарт связан с дополнительными трудностями и железки показывают худшие результаты, чем в одиночных конфигурациях.

О чём нельзя забывать

При разгоне компонентов (особенно с повышением их напряжения) повышается их энергопотребление и тепловыделение. Это даёт важные следствия:

1. Для разогнанных компонентов необходимо более эффективное охлаждение;

2. Для разогнанной системы необходима большая мощность блока питания.

Именно пренебрежительное отношение к этим двум следствиям порождает проблемы в процессе разгона.

3. Разогнанная система менее экономична в плане потребления электроэнергии.

А это ставит под большой вопрос целесообразность разгона ноутбуков.

Подробному разбору вопросов питания и охлаждения будет посвящена данного материала. Пока же просто стоит запомнить и усвоить эти важные замечания.

А ещё выход железа из строя вследствие разгона является негарантийным случаем. Хотя в не очень прямых руках вообще что угодно сломаться может ;)

Вместо вывода

Знание некоторых железных тонкостей открывает перед пользователем новые, прежде скрытые горизонты.

Разгон представляет собой отличный способ повысить производительность своей системы, ничего не потеряв, а игнорирование такой возможности — настоящее кощунство.

На этом проблему выбора ключевых компонентов можно считать решённой. Конечно, не на все вопросы были даны ответы, но определенная ясность в ситуацию уже внесена. Если что-то совсем непонятно — готов ответить в комментариях ;)

Следующая же часть материала будет посвящена ещё одному очень важному компоненту системы — материнской плате.

P.S. Извиняюсь за двухнедельную задержку, но всё никак не получалось довести статью до ума. То дела, то просто «креатифф не пёр». Вот только сегодня закончил. Сейчас со временем вроде стало посвободнее, так что следующие части будут выходить быстрее =)

P.P.S. Ещё раз напоминаю, что данный цикл статей направлен не на гуру-железячников, техноманьяков и экстремальных оверклокеров, а на обычных людей, близких к IT, но плохо разбирающихся именно в железной области.

P.P.P.S.